Sicherheit ohne Einbußen bei Performance

Sicher, schnell und kostengünstig: das Internet als internationale Geschäftsplattform

Grundlagen der sicheren und schnellen Bereitstellung von Anwendungen

über das Internet

Fachbeitrag

Von Harald Prokop, Akamai Technologies

(12.04.10) - Zunehmende Globalisierung und eine angespannte Wirtschaftslage sind Gründe, die immer mehr Unternehmen dazu bringen, ihre Anwendungen in das Internet zu verlagern. Immer häufiger wird das World Wide Web als Geschäftsplattform genutzt, die ein Unternehmen zu jeder Zeit und von jedem Ort aus mit seinen Kunden, Partnern und externen Mitarbeitern weltweit kostengünstig verbindet. Trotz seiner grundsätzlichen Flexibilität und Kosteneffizienz ist das Internet jedoch per se keine sichere, hochverfügbare und performante Geschäftsplattform, weist es doch ganz klare Schwächen auf:

* Mangelnde Perimeter-Sicherheit: Im Gegensatz zu privaten WANs existieren außerhalb des Rechenzentrums keine Kontrollpunkte oder Gateways. Die Firewall des Rechenzentrums kann somit zum Fokus gezielter Angriffe werden.

* Anfälligkeit von HTTPS- und VPN-Verbindungen: Remote-Anwender, die HTTPS oder VPNs als Zugangsoptionen nutzen, sind den Unwägbarkeiten des Internets in Bezug auf Performance und Verfügbarkeit schutzlos ausgeliefert. Diese äußern sich in hohen und extrem schwankenden Latenzzeiten sowie mangelnder Effizienz der TCP- und HTTP-Technologie.

* Fragmentierte Business-Continuity-Lösungen: Wird die Business Continuity außerhalb der Firewall, d.h. zwischen den Anwendern und den primären und Failover-Standorten, nicht in die gesamte redundante IT-Infrastruktur mit einbezogen, steht und fällt das Tagesgeschäft mit der aktuellen Verfügbarkeit des Internets.

Grundlagen der sicheren und schnellen Anwendungsbereitstellung

Um diese Herausforderungen für Internetapplikationen zu meistern, wird eine globale Infrastruktur benötigt, die auf dem Internet aufsetzt und so ein intelligentes Overlay-Netzwerk bildet. Dadurch entsteht eine virtuelle private WAN-Umgebung innerhalb des Internets, die eine sichere Verbindung mit Kunden, Partnern und Mitarbeitern ermöglicht und gleichzeitig für ein Höchstmaß an Verfügbarkeit und Leistungsfähigkeit sorgt.

Die Wirksamkeit der Strategie eines globalen Overlay-Netzwerks wird maßgeblich durch die Verteilung und räumliche Nähe intelligenter Kontrollpunkte am Rande der Internetwolke bestimmt. Durch eine geringe Entfernung von lediglich einem "Network Hop" zum Endanwender beziehungsweise zur Anwendungsinfrastruktur lässt sich eine binodale, symmetrische Kontrolle der so genannten "Middle Mile" erreichen. Dies bringt folgende Vorteile mit sich:

Schaffung von Remote- und lokalen Perimeter-Firewalls innerhalb der Internetwolke, um so den Zugang zu Unternehmensinhalten zu kontrollieren und Internetattacken abwehren zu können.Intelligente Auswahl von Pfaden zwischen den Anwendern und dem Rechenzentrum zur Erzielung kürzester und konsistenter Latenzzeiten, um die Performance nachhaltig zu steigern.Intelligentes Routing des Datenverkehrs zwischen den Anwendern und dem Rechenzentrum, um Engpässe und Verfügbarkeitsprobleme im Internet zu umgehen.Anpassung der standardmäßigen TCP- und HTTP-Protokolle, sodass die Anzahl der Roundtrips verringert und der Datendurchsatz maximiert wird. Die wiederholte Übertragung angeforderter Inhalte sowie Client-Antwortzeiten werden minimiert.

HTTPS zur sicheren Bereitstellung von Unternehmensanwendungen

Da immer mehr Unternehmen ihre Anwendungen für Partner und Kunden über das Internet bereitstellen, steigt auch das unternehmerische Risiko durch immer neue Sicherheitsgefährdungen. Zu solchen Risiken gehören beispielsweise Hacker-Angriffe, Viren und Internetwürmer ebenso wie Denial-of-Service- (DoS)-Attacken oder das böswillige Verfälschen von Inhalten.

Unternehmenslösungen im Internet werden daher an der Sicherheit im privaten WAN gemessen. Dieses verfügt über zahlreiche Kontrollpunkte außerhalb des Rechenzentrums, mit denen sich ein mindestens zweistufiges Sicherheitskonzept realisieren lässt. Da Kunden und Geschäftspartner aber meist außerhalb des privaten WAN angesiedelt sind und nicht zum Unternehmen gehören, scheidet für diesen Anwenderkreis die Nutzung von VPN-Technologie aus geschäftlichen und technischen Gründen oftmals aus.

Die Einbindung von externen Parteien ist aufgrund deren sich ständig verändernden Beziehungen zum Unternehmen über eine VPN-basierte Technologie äußerst schwierig. Aus technologischer Sicht kommt erschwerend hinzu, dass VPN-Gateways erheblich mehr Kosten als Nutzen verursachen können, da zusätzlich zur Administration des Gateways auch bei den Anwendern Aufwand für Wartung und Support entsteht. Daher hat sich die Verschlüsselung über HTTPS-Verbindungen heutzutage breitflächig als Standard durchgesetzt. Diese Technologie bietet die nötige Flexibilität und hat sich bei der sicheren Bereitstellung von Unternehmensanwendungen bewährt.

Ein hohes Maß an Sicherheit, ähnlich einer VPN-Verbindung, wird über eine Verlagerung der Kontrolle in die Internet-Wolke erreicht. Über einen solchen Edge-Perimeter-Ansatz vom Rande des Internet aus können Angriffe bereits abgefangen werden, noch bevor sie die Unternehmensinfrastruktur erreichen.

Der beste Lösungsansatz hierfür ist der Einsatz eines Overlay-Netzwerks, das auf dem Internet aufsetzt. Es schafft eine intelligente, mehrstufige Perimeter-Sicherheit und ermöglicht gleichzeitig die globale Beschleunigung von Anwendungsservices über eine zentrale Infrastruktur.

* Blockierung von "Malformed Requests": Da das Overlay-Netzwerk als Proxy für eine Anfrage dient, kann der vorgelagerte, intelligente Abwehrmechanismus diese Art von Anfragen und Datenpaketen bereits im Vorfeld abfangen, bevor sie die eigentliche Applikationsinfrastruktur erreichen.

* Zugriffskontrolllisten: Da die Anwender über das Overlay-Netzwerk eine Verbindung mit dem Firmennetz herstellen, können Zugriffskontrolllisten in den Edge-Bereich verschoben werden, um so den Zugriff einzelner Anwender zu gestatten bzw. zu unterbinden.

* Schutz des Ausgangsservers: Der Applikationsserver befindet sich hinter dem Overlay-Netzwerk, das so einen wirksamen Schutz bietet. Der Zugriff auf die IP-Adresse des Servers von außen wird blockiert, nur der von einem nahegelegenen Edge-Kontrollpunkt des Overlay-Netzwerks stammende Traffic erreicht den Applikationsserver.

* Schutz gegen DDOS-Attacken: Da das Overlay-Netzwerk die Auslieferung von Inhalten und Daten für den Ausgangsserver übernimmt, kann es auch DDOS-bedingte Traffic-Spitzen abwehren und den Ausgangsserver vor Angriffen, die andernfalls durch ihre Tarnung als gewöhnliche Dateien oder Objekte als valide zugelassen werden, schützen.

Sicherheit ohne Performanceverlust

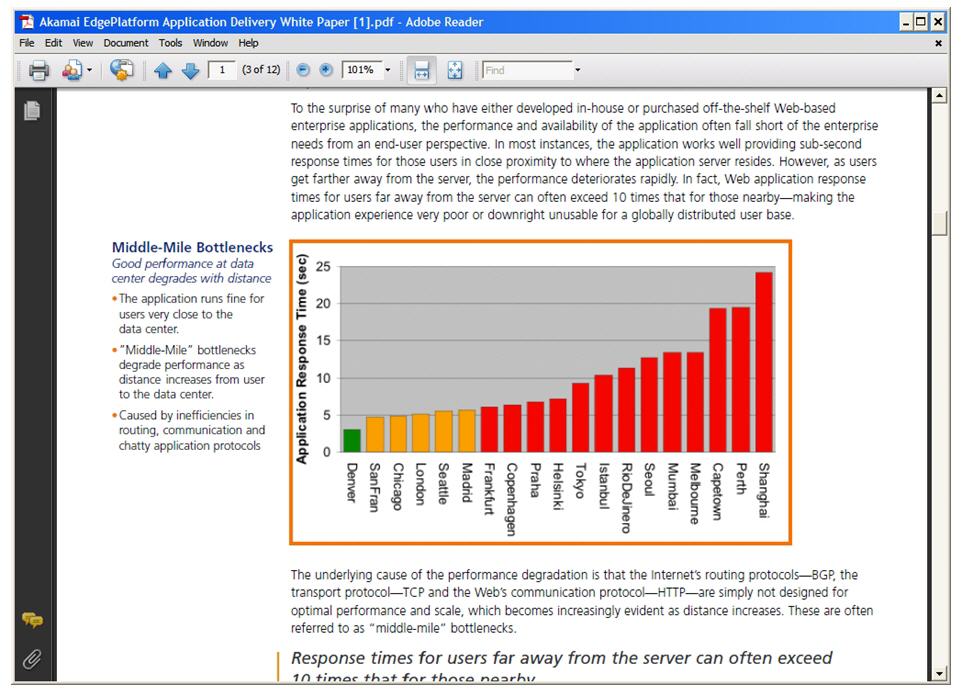

Kunden, Partner und Angestellte sind im Allgemeinen weit verstreut. Wie in dem unten stehenden Diagramm aufgeführt, verschlechtert sich die Antwortzeit für den Endanwender, je weiter dieser von der Webapplikation entfernt ist. Tatsächlich kann die Antwortzeit von Webanwendungen für Internetnutzer, die sich in weiter Entfernung zum Server befinden, bis zu zehn Mal höher sein als für diejenigen, die näher dran sind. Dies führt entweder zu einem schlechten Anwendererlebnis oder macht die Applikation für eine globale Zielgruppe sogar völlig unbrauchbar.

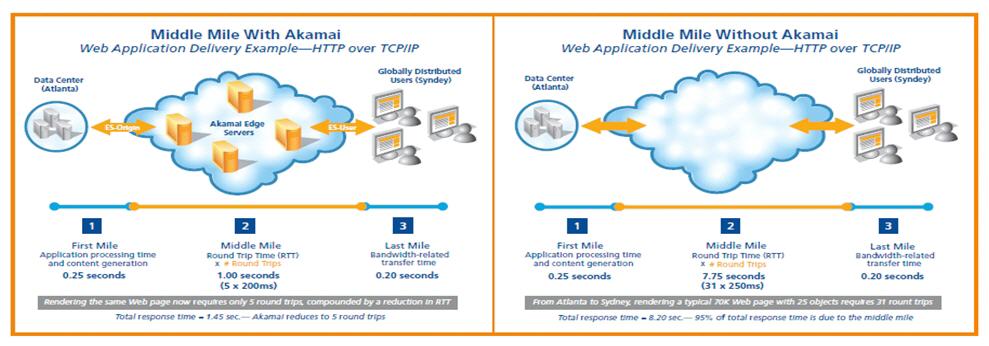

Der Grund für die Performance-Verschlechterung liegt darin, dass die Internetprotokolle – das Border Gateway Protocol (BGP), das Transmission Control Protocol (TCP) und das Hypertext Transfer Protocol (HTTP) - nicht geeignet sind, eine optimale Performance und Skalierung sicherzustellen, was sich mit zunehmender Entfernung immer deutlicher zeigt. Diese Engpässe werden oftmals auch als "Middle Mile Bottlenecks" bezeichnet, da sie in der Middle Mile der Internet Cloud zwischen dem Webbrowser des Endanwenders und der Webapplikation anzusiedeln sind.

Folgende Ansätze zur Verbesserung der Anwendungsauslieferung werden bisher verfolgt:

1. Ausbau des Rechenzentrums

2. Application Delivery Appliances

3. Traditionelle Content Delivery Network (CDN) Services

4. Application Delivery Network (ADN) Services

1. Der Ausbau von Rechenzentren dient dazu, den Umfang an Servern und Bandbreite zu erhöhen und die Nachfrage besser bedienen zu können. Anwendungen und Inhalte werden dabei näher an räumlich weit verteilte Endanwender herangebracht. Allerdings sind mit dieser Methode mehrere Probleme verbunden. Erstens ist ein Ausbau der Infrastruktur zum Abfedern von Traffic-Spitzen kostenintensiv. Zudem wird es immer Phasen geben, in denen diese Infrastruktur nicht oder nicht erschöpfend genutzt wird und dadurch das Unternehmen als brachliegendes Kapital belastet. Auch erfordert die Behebung von Middle-Mile-Engpässen für Nutzer in der Nähe des Rechenzentrums eine Datenreproduktion und -synchronisierung, was wiederum zusätzliche Kosten, mehr Komplexität und höhere Compliance-Risiken mit sich bringt.

2. Spezielle Appliances erhöhen die Skalierbarkeit und optimieren die Anwendungsauslieferung. Application Delivery Controllers (ADC) ermöglichen ein L4- bis L7-Switching und bieten Funktionen wie Local Load Balancing, SSL Offload und Kompression. Dabei handelt es sich um zentrale Lösungen, da sie im Rechenzentrum des Unternehmens direkt vor den Webserver geschaltet und nicht in der Internet Cloud angesiedelt sind. Die Auswirkungen eines Application Delivery Controllers sind auf das Rechenzentrum beschränkt, er kann keine binodale Optimierung durch die Positionierung von Prozessintelligenz oder Services in der Nähe des Endnutzers leisten. Somit sind die Möglichkeiten, Middle-Mile-Engpässe auszugleichen, begrenzt, was zu suboptimalen RTT (Round Trip Time) und RTT-Multiplikatoren führt.

3. Traditionelle CDNs sind in der Lage, statischen Content näher am Endnutzer zwischenzuspeichern und setzen dafür gewöhnlich eine zentralisierte Architektur mit einer geringen Anzahl an Server Locations ein. Diese Netzwerke sind dagegen nicht geeignet, dynamische, webfähige Unternehmensanwendungen schnell und sicher auszuliefern, da sie nicht die damit einhergehenden Middle-Mile-Engpässe adressieren.

4. ADN Services haben sich als umfassende Internet-basierte Plattform zur Performance-Verbesserung von Webapplikationen profiliert. ADNs übertreffen traditionelle CDNs und Application Delivery Appliances, indem sie helfen, First-Mile- und Middle-Mile-Engpässe gleichermaßen zu überwinden und darüber hinaus die Auslieferung von dynamischen Anwendungen, statischem Content sowie Webservices zu optimieren. Als "zweite Haut über dem Internet" kombinieren ADN Service Provider die von Application Delivery Appliances und CDNs eingesetzten Techniken, um das Internet in eine hochperformante Auslieferungsplattform für Web- und IP-basierte Anwendungen umzuwandeln.

Die Grundlage eines ADN ist ein globales Netzwerk aus spezialisierten Servern, die durch optimierte Protokolle miteinander verbunden sind. Somit entsteht eine auf dem Internet aufsetzende, transparente Plattform, über die die Auslieferung von Anwendungen und Inhalten bedarfsgerecht optimiert wird. Eine flächendeckende Verteilung der Server ist dabei entscheidend, um intelligente Endpunkte möglichst nah am Endnutzer und gleichzeitig am Anwendungsserver zu positionieren. Mit der Errichtung dieser beiden Endpunkte ist das ADN in der Lage, ineffizientes Protokollverhalten über das weitläufige Middle-Mile-Segment, in dem die große Mehrheit der Performance-Verschlechterung passiert, umzuwandeln.

ADN-Techniken teilen sich in drei Hauptkategorien:

>> Route Optimization: Behebung von BGP-Ineffizienz, die ein langsames Routing verursacht, indem über die Edge-Server-Plattform eine Echtzeit-Zustandskarte des Internets als Grundlage für Performance-basierte Routing-Entscheidungen zur Verfügung gestellt wird

>> Transport Optimization: Vermeidung des Round-Trip-Multiplier-Effekts durch eine effizientere Kommunikationstechnik innerhalb von TCP und HTTP zwischen Anwendungs- und Edge-Server in der Nähe des Endnutzers

>> Application Optimization

Das ADN erfüllt dabei die wichtigsten Voraussetzungen für die Optimierung der Protokollkommunikation. So wird eine Reihe beständiger Kommunikationsverbindungen zwischen Anwendungsserver und Endnutzer hergestellt, über die wiederum die Bündelung mehrerer HTTP-Anfragen über eine einzige Verbindung (Pipelining) möglich ist. Über genaues Wissen zum aktuellen Netzwerkzustand (z.B. Bandbreite, Latenz) kann in der optimalen Fenstergröße kommuniziert werden, was lange Startzeiten vermeidet.

Zu den Techniken, die ausschlaggebend für eine performante Bereitstellung von Webapplikationen sind, gehören:

>> Intelligentes Pre-Fetching: Bei einer Abfrage der Basisseite über den ADN-Edge-Server wird gleichzeitig eine Vorabfrage für die eingebetteten Objekte getätigt. Der gesamte Inhalt wird dann mithilfe des optimierten Protokolls in einer einzigen Transaktion zum Edge-Server geleitet. Wenn der Browser die Basisseite empfängt und dann die fehlenden Elemente der Seite anfragt, stehen diese schon zum Abruf auf dem Edge-Server in der Nähe des Endnutzers bereit und werden so innerhalb von Millisekunden ausgeliefert.

>> Komprimierung: Die Daten werden unterwegs komprimiert, wodurch sich die benötigte Bandbreite verringert.

>> Caching: Jeder cachefähige Inhalt wird im Edge-Server in der Nähe des Endnutzers vorgehalten und über den Zwischenspeicher ausgeliefert.

Dank der Möglichkeit, die Auslieferung dynamischer Anwendungen und Webservices zu optimieren, versetzen ADNs Unternehmen in die Lage, ihre Infrastruktur zu zentralisieren, ohne dabei Abstriche bei der Sicherheit, Performance und Verfügbarkeit ihrer Anwendungen machen zu müssen.

In der Summe bietet das ADN folgende Vorteile:

>> LAN-ähnliche Performance für globale Nutzer: Die Verbindung aus weltweit verteilten Edge-Servern, optimiertem Routing und Protokollkonversion sorgt bei der Abfrage dynamischer Anwendungen und Webservices für LAN-ähnliche Antwortzeiten überall auf der Welt.

>> Hohe Verfügbarkeit: Dynamischer Inhalt wird vom Anwendungsserver mithilfe von Route Optimization in Echtzeit an Internet-Engpässen sicher vorbei geleitet.

>> Voraussehbare Kapazität: entspricht den Anforderungen dynamischer Anwendungen und Webservices, die jederzeit das Tausendfache des normalen Traffic-Niveaus erreichen können.

>> Minimale Total Cost of Ownership (TCO): Die Kosten werden transparent gehalten, da die TCO lediglich dem Betrag für die monatlichen Services entsprechen. Zudem ist keine Anpassung von Anwendungen und Infrastruktur erforderlich, was zu einer schnellen Time to Value und einem niedrigen Risiko führt.

>> Unternehmenssicherheit: sichere und beschleunigte Auslieferung von SSL-Anwendungen, wobei eine nahtlose Integration in bestehende Authentifizierungssysteme und -prozesse, wie beispielsweise die Unterstützung von X.509 Client-basierten Zertifikaten oder der PCI Compliance für eCommerce, möglich ist.

Das Internet bietet also eine attraktive Lösung für Unternehmen, um ihre Infrastrukturkosten zu senken und die betriebliche Effizienz außerhalb der Firewall zu erhöhen. Um die Business Continuity zu wahren, ist dabei eine Absicherung der über das Internet hergestellten Verbindungen gegen hohe Latenzzeiten und Datenverluste essenziell. Mit ADN Services lässt sich eine redundante Perimeter-Sicherheit innerhalb der Internet-Wolke herstellen. Global aufgestellte Unternehmen können somit ihren weltweit verteilten Kunden, Partnern und Mitarbeitern Zugang zu Webapplikationen verschaffen, ohne Zugeständnisse an Sicherheit, Zuverlässigkeit und Performance machen zu müssen. (Akamai Technologies: ra)

Dieser Artikel ist eine Anzeige der Firma Akamai.

Sie zeichnet auch für den Inhalt verantwortlich.

Akamai Technologies: Kontakt und Steckbrief

Der Informationsanbieter hat seinen Kontakt leider noch nicht freigeschaltet.